Садржај

П:

Зашто је умјетно понављајуће неуронске мреже често тешко тренирати?

А:

Тешкоћа у тренингу вештачких понављајућих неуронских мрежа има везе са њиховом сложеношћу.

Један од најједноставнијих начина да се објасни зашто је непрекидне неуронске мреже тешко обучити је да оне нису напредне неуронске мреже.

У напредним неуронским мрежама сигнали се крећу само у једном смеру. Сигнал се креће од улазног слоја до различитих скривених слојева и напред до излазног слоја система.

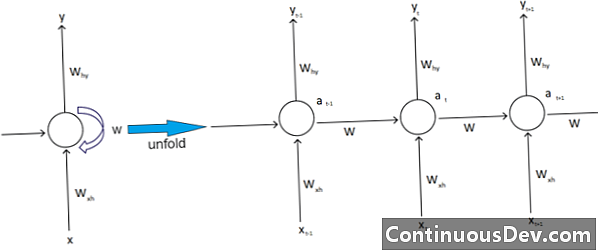

Насупрот томе, понављајуће неуронске мреже и друге различите врсте неуронских мрежа имају сложеније покрете сигнала. Класифициране као "повратне" мреже, понављајуће неуронске мреже могу имати сигнале који путују и напред и назад и могу садржавати различите "петље" у мрежи где се бројеви или вредности враћају назад у мрежу. Стручњаци то повезују с аспектом понављајућих неуронских мрежа који су повезани са њиховом меморијом.

Поред тога, постоји друга врста сложености која утиче на понављајуће неуронске мреже. Један одличан пример за то је у области обраде природног језика.

У софистицираној обради природног језика, неуронска мрежа мора бити у стању да се сети ствари. И он мора да прихвати инпуте. Претпоставимо да постоји програм који жели да анализира или предвиди реч унутар реченице других речи. На пример, систем може да процени фиксну дужину од пет речи. То значи да неуронска мрежа мора да има улазе за сваку од ових речи, заједно са способношћу да се "сети" или тренира на основу ових речи. Из тих и других сличних разлога, понављајуће неуронске мреже обично имају ове мале скривене петље и повратне информације у систему.

Стручњаци жале како ове компликације отежавају тренирање мрежа. Један од најчешћих начина да се то објасни је наводећи експлодирајући и нестајући проблем градијента. У основи, тежине мреже ће или довести до експлозије или нестајања вредности са великим бројем пролаза.

Пионир неуронске мреже Геофф Хинтон објашњава ову појаву на мрежи рекавши да ће назадни линеарни пролази узроковати да се мале тежине експоненцијално смањују, а веће тежине да експлодирају.

Овај проблем, наставља он, се погоршава дугим низовима и бројнијим временским корацима, у којима сигнали расту или пропадају. Иницијализација тежине може помоћи, али ти су изазови уграђени у понављајући модел неуронске мреже. То ће увек бити проблем у вези са њиховим дизајном и изградњом. У суштини, неки од сложенијих типова неуронских мрежа заиста пркосе нашој способности да их лако управљамо. Можемо створити практично бесконачну количину сложености, али често видимо како предвидивост и скалабилност изазови расту.